No universo do Business Intelligence moderno, lidar com grandes volumes de dados de forma eficiente é um desafio constante. O Microsoft Fabric surge como uma plataforma unificada que simplifica a arquitetura de dados, e a sua integração com o Apache Spark é o coração da sua capacidade de processamento de dados em escala.

Neste post, vamos explorar como esta poderosa combinação funciona. Começaremos por entender o papel do Spark no processamento distribuído e as suas principais vantagens, e depois, mostraremos como é fácil configurar e otimizar um cluster Spark dentro do ambiente do Fabric.

1. Visão Geral do Microsoft Fabric

O Microsoft Fabric consolida, numa única plataforma, funcionalidades como Data Warehousing, Data Engineering, processamento em tempo real, Data Science e Machine Learning, facilitando a gestão integrada da informação.

2. Como é que o Spark funciona?

O Apache Spark é um mecanismo de processamento distribuído que funciona através de uma arquitetura master-worker com paralelismo inerente, permitindo processar grandes volumes de dados através de múltiplas máquinas de forma coordenada.

2.1. Arquitetura de Paralelismo no Spark

O Spark opera numa arquitetura hierárquica composta por dois tipos principais de nós: o master node (também designado por driver) e os worker nodes (que executam executors). Esta distribuição permite ao Spark dividir tarefas complexas em operações mais pequenas que são executadas em paralelo.

O driver node atua como o coordenador central do cluster, sendo responsável por:

- Analisar, distribuir e agendar tarefas entre os executors

- Manter o SparkContext, que representa a ligação ao cluster Spark

- Monitorizar o progresso da execução e garantir tolerância a falhas

Os worker nodes contêm os executors, que são processos responsáveis pela execução real das tarefas. Cada executor tem duas responsabilidades principais:

- Executar o código atribuído pelo driver/worker node

- Reportar o progresso dos cálculos de volta ao driver node

2.2. Funcionamento do Paralelismo

O paralelismo no Spark é alcançado através da divisão dos dados em partições distribuídas pelos diferentes nós do cluster. Cada partição é processada independentemente por diferentes threads, permitindo operações simultâneas. Por exemplo, se um dataset for dividido em múltiplas partições de 128MB cada, diferentes executors podem processar estas partições em paralelo, maximizando a utilização dos recursos computacionais.

O Spark cria um DAG (Directed Acyclic Graph) para programar tarefas e orquestrar os nós worker no cluster. Este mecanismo permite otimizar a sequência de operações e facilita a recuperação em caso de falhas, replicando apenas as operações necessárias nos dados de um estado anterior.

3. Configurações Spark no Microsoft Fabric

3.1. Pré-requisitos

- Acesso ao portal do Microsoft Fabric com as permissões necessárias (admin, contributor ou member)

- SKU de Fabric previamente contratado OU Fabric Trial ativo

3.2. Passos para Configuração

Configuração de Clusters Pre-warmed

O Microsoft Fabric oferece Starter Pools que utilizam clusters pre-warmed executados em máquinas virtuais da Microsoft para reduzir significativamente os tempos de início. Estes clusters estão sempre ativos e prontos para utilização, proporcionando inicialização de sessões Spark tipicamente entre 5 a 10 segundos, sem necessidade de configuração manual.

Os Starter Pools utilizam nós de tamanho médio que escalam dinamicamente com base nas necessidades dos trabalhos Spark. Quando não há dependências de bibliotecas personalizadas ou propriedades Spark customizadas, as sessões iniciam quase instantaneamente porque o cluster já está em execução e não requer tempo de provisionamento.

No entanto, existem cenários onde o tempo de início pode ser maior:

- Bibliotecas personalizadas: Adiciona 30 segundos a 5 minutos para personalização da sessão

- Alta utilização regional: Quando os Starter Pools estão saturados, pode demorar 2-5 minutos para criar novos clusters

- Opções de rede: Private Links ou Managed VNets desativam os Starter Pools, forçando criação on-demand

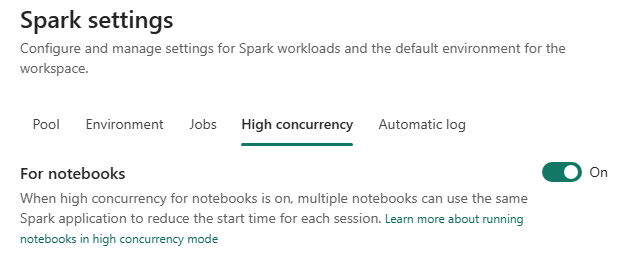

Ativação do High Concurrency Mode

Recomenda-se ativar o High Concurrency Mode para permitir que múltiplos notebooks partilhem a mesma sessão Spark, otimizando a utilização de recursos e reduzindo drasticamente os tempos de início. Em pools personalizados com high concurrency, os utilizadores obtêm uma experiência de início de sessão extremamente mais rápida comparativamente a sessões Spark standard.

Para ativar o High Concurrency Mode:

- Aceder às Workspace Settings

- Navegar para Data Engineering/Science > Spark Settings > High Concurrency

- Ativar a opção For notebooks

Especificações Recomendadas para Pools

Para demonstrar as configurações ideais, consideremos um exemplo com SKU F64:

Capacidade Base:

- F64 = 64 Capacity Units = 128 Spark VCores

- Com burst factor 3x = 384 Spark VCores máximos (o burst factor multiplica a capacidade de processamento disponível para aumentar o desempenho)

Configuração Recomendada para Pool Personalizado:

| Parâmetro | Valor Recomendado | Explicação |

|---|---|---|

| Node Family | Memory Optimized | Adequado para workloads de processamento de dados |

| Node Size | Medium (8 VCores) | Equilíbrio entre performance e concorrência |

| Autoscale | Ativado (min: 2, max: 48) | 48 nós × 8 VCores = 384 VCores (máximo burst) |

| Dynamic Allocation | Ativado | Permite ajuste automático de executors conforme demanda |

Configuração de Dynamic Allocation:

- Min Executors: 2 (baseline para disponibilidade imediata)

- Max Executors: 46 (reservando 2 nós para driver e overhead)

- Initial Executors: 4 (equilibrio entre startup e resource waste)

Dimensionamento Baseado no SKU:

Para diferentes SKUs, as configurações máximas variam:

| SKU | Capacity Units | Max Spark VCores | Node Size Recomendado | Max Nodes |

|---|---|---|---|---|

| F2 | 2 | 12 | Small | 3 |

| F8 | 8 | 48 | Medium | 6 |

| F16 | 16 | 96 | Medium | 12 |

| F64 | 64 | 384 | Medium/Large | 48/24 |

| F128 | 128 | 768 | Large | 48 |

Configuração Através do Portal

No portal do Microsoft Fabric:

- Aceder à secção Engenharia de Dados > Spark Settings

- Selecionar New Pool para criar um cluster personalizado

- Definir o Node Family e Node Size conforme os requisitos

- Configurar Autoscale com número mínimo de nós = 1 (Fabric garante disponibilidade restaurável mesmo com single node)

- Ativar Dynamic Executor Allocation para otimização automática de recursos

Integração com Fontes de Dados:

- Utilizar conectores nativos para estabelecer ligações a Data Lakes ou Data Warehouses

- Verificar que as credenciais e configurações de segurança estão corretamente definidas

Configuração de Notebooks e Tarefas:

- Configurar notebooks (Python ou Scala) para desenvolvimento de scripts de transformação

- Agendar tarefas batch ou configurar processos streaming conforme requisitos

Os pools personalizados têm um autopause padrão de 2 minutos, após o qual as sessões expiram e os clusters são desalocados, sendo cobrado apenas pelo tempo de utilização ativa.

É claro que as parametrizações ideais do cluster podem variar tendo em conta os processos que serão executados. Deve sempre ser realizada uma avaliação acompanhada de testes para cada caso.

4. Melhores Práticas e Considerações Técnicas

Dimensionamento e Otimização

É fundamental dimensionar correctamente o cluster. Considere:

Burst Factor: Determine a capacidade de escalabilidade instantânea necessária para lidar com picos de processamento. A lógica deve incluir a multiplicação do número de VCores utilizados na seleção, permitindo atingir o burst factor requerido. Por exemplo, para um SKU F64 (128 VCores base), configure o pool para até 384 VCores, ajustando o número de nós e o tamanho de nó (exemplo: Medium nodes (8 VCores cada) × 48 nós = 384 VCores).

Número de Cores e Memória: Para o driver node, selecione um número adequado de cores e memória, uma vez que ele orquestra o processamento e deve suportar as tarefas de gestão do cluster. Nos worker nodes, a escolha deve ser baseada na multiplicação dos recursos (núcleos e memória) necessários para o processamento paralelo. Avalie a possibilidade de escalonar estes nós para ajustar o desempenho conforme a carga.

Automatização e Agendamento

Automatize processos recorrentes através de scripts e agendamentos, garantindo consistência e minimizando erros.

Monitorização

Utilize as ferramentas de monitorização nativas do Fabric para identificar possíveis problemas e ajustar o desempenho do cluster em tempo real.

Segurança

Assegure a implementação de políticas de segurança robustas, configurando permissões e utilizando ligações seguras para o acesso aos dados.

Quais os próximos passos?

A B2F dispõe de uma sólida experiência no desenvolvimento de soluções em Microsoft Fabric, assim como na implementação de processos baseados em Spark. Caso necessite de apoio especializado para maximizar o desempenho e a eficiência da sua plataforma analítica, a nossa equipa está preparada para colaborar consigo e encontrar as melhores soluções para os seus desafios.